Le collectif néerlandais Bits of Freedom (membre de l'EDRi, European Digital Rights) a contesté un projet municipal qui utilise une IA pour faire de la justice prédictive (programme Amsterdam Top400). Il remet en cause ce programme pour violations des droits de l'enfant, non respect de la loi sur la protection des données et des libertés fondamentales.

En France, si ce type de programme ne semble pas relever des municipalités, la tentation d'une justice pilotée par l'IA existe aussi, un rapport a d'ailleurs été remis en juin 2025 (voir encadré à la fin de l'article).

Amsterdam Top400

En 2015, la municipalité d'Amsterdam a créé Top400, un programme de prévention de la délinquance ciblant des jeunes, en complément de Top600 , une liste de 600 jeunes récidivistes auteurs de crimes graves. Contrairement à Top600, l'inscription sur la liste de Top400 ne nécessitait pas de condamnation pénale.

Des enfants pouvaient être ajoutés à la liste en fonction d'un large éventail de critères, notamment le fait d'être soupçonné d'une infraction pénale, d'avoir changé fréquemment d'école, d'être victimes ou témoins de violence domestique ou d'autres crimes, ou d'être frères et sœurs d'une personne figurant sur la liste Top600.

Pendant deux ans, un algorithme a servi à sélectionner des jeunes. Une fois inscrits, ces enfants étaient étroitement surveillés par la municipalité, la police, l'école, des "animateurs de rue" et des dizaines d'autres partenaires.

Le programme, à la croisée de la prise en charge et de la répression, fonctionnait comme un système de surveillance et de contrôle, entraînant la stigmatisation des jeunes et une méfiance accrue envers les institutions. Malgré son impact, il n'a jamais fait l'objet d'une évaluation adéquate du point de vue de la communauté concernée.

Réunir différents types d'expertise

Une coalition s'est formée afin d'en contester les effets. Elle a rassemblé différentes organisations et des personnes aux expertises variées, aux côtés des communautés affectées. Fair Trials a apporté son éclairage sur l'utilisation de listes similaires au Royaume-Uni. Controle Alt Delete a également participé, en faisant part du point de vue des jeunes Néerlandais victimes de harcèlement policier. Les avocats du Public Interest Litigation Project (PILP) et la chercheuse Fieke Jansen ont lancé une enquête en vertu de la loi sur la liberté d'information (FOIA). Grâce à cette enquête, la coalition a pu accéder à des documents de politique générale et comprendre le fonctionnement prévu du programme par la municipalité, ainsi que ses impacts et ses conséquences néfastes.

Les résultats de l'enquête menée en vertu de la loi sur la liberté d'information (FOIA) ont été publiés dans un rapport, diffusé simultanément avec le documentaire "Mothers" réalisé par Nirit Peled, journaliste et documentariste. Cette initiative a permis de maximiser l'impact médiatique. Le rapport et le documentaire ont tous deux mis en lumière l'injustice et les malversations de la municipalité d'Amsterdam, ainsi que leurs conséquences sur la vie des enfants et de leurs familles. Le maire, quant à lui, a continué de défendre le projet dans les médias et semblait refuser de mettre fin à ces pratiques illégales.

Face à cette résistance, nous avons décidé d'explorer les possibilités de recours contentieux , en nous appuyant sur une analyse juridique préparée par un avocat de notre coalition. Résultat : nous pouvions poursuivre la municipalité pour plusieurs violations du Règlement général sur la protection des données (RGPD), ainsi que de la Convention relative aux droits de l'enfant et de l'article 8 de la Convention européenne des droits de l'homme.

Placer les personnes concernées au centre de la prise de décision

La mise en place d'un groupe consultatif composé de personnes issues de la communauté concernée était une condition préalable indispensable à la réalisation du projet. PILP a pu s'entretenir avec plusieurs personnes figurant parmi les 400 bénéficiaires du programme et d'autres membres de la communauté.

Si beaucoup reconnaissaient la nécessité d'agir, ils hésitaient à s'impliquer directement ou à afficher leur lien avec l'initiative. Devenus adultes et ayant quitté le programme, ils souhaitaient, à juste titre, tourner la page. Néanmoins, plusieurs personnes ont finalement accepté de participer à notre groupe consultatif.

Au cours de plusieurs réunions, nous avons expliqué la situation juridique, les différentes options possibles et leurs conséquences. Les participants ont ensuite partagé leurs expériences et indiqué les prochaines étapes les plus utiles.

Ces réunions se sont tenues entre chaque action entreprise afin de garantir l'implication active des personnes concernées dans l'élaboration de la stratégie. Très vite, il est apparu clairement que nombre d'entre eux vivaient encore avec des traumatismes, des douleurs et de la peur.

Nous avons décidé de préparer une action en justice contre la municipalité d'Amsterdam, avec Bits of Freedom comme partie prenante, représentée par PILP.

Préparation au tribunal

Nous avons formellement exhorté la municipalité à mettre fin à la surveillance secrète par les accompagnateurs de rue, à cesser le partage obligatoire et généralisé d'informations entre le directeur du programme et les écoles, à indemniser financièrement les personnes sélectionnées par l'algorithme et à publier une déclaration reconnaissant le caractère contraire à l'éthique de cette pratique.

Dans sa réponse, la municipalité a partiellement accédé à deux de nos trois demandes : elle a accepté de mettre fin à la surveillance secrète et de limiter le partage de données avec les écoles. Elle a proposé d’élaborer de nouveaux documents afin de clarifier sa position.

Mais lorsque les représentants du gouvernement se sont rendus auprès de la maire pour obtenir son approbation, celle-ci a refusé et a maintenu sa position sur l'approche du Top400. Selon elle, aucun acte illégal n'ayant été commis, un accord était impossible.

La procédure de règlement a été longue, mais elle a porté ses fruits : la municipalité a rédigé de nouveaux documents de politique générale pour améliorer les pratiques concernant les autocars et les écoles. Cependant, elle n’a pas permis de remédier au préjudice subi par les personnes sélectionnées par l’algorithme.

Changement de stratégie nécessaire

De ce fait, la procédure en justice que nous considérions auparavant très prometteuse s'est retrouvée avec peu de chances d'aboutir : le risque était réel qu'un juge estime les éléments insuffisants pour statuer sur l'affaire. Une défaite en justice aurait pu avoir des conséquences négatives plus importantes, légitimant des pratiques similaires à Amsterdam et ailleurs.

Nous avons donc étendu notre action à la protection des droits de l'enfant, notamment en ce qui concerne l'utilisation de technologies telles que l'IA, une priorité absolue. La pratique du profilage des citoyens, en particulier des enfants, par la municipalité d'Amsterdam s'inscrit dans une tendance plus large où les gouvernements utilisent des outils basés sur les données pour jeter le soupçon sur des individus sans fondement formel. Il nous faut souligner les conséquences pour les enfants, les familles, notre société et l'État de droit.

Nos conclusions

Au fil du temps, nous avons identifié un certain nombre d'idées qui ont renforcé notre approche et qui pourraient être utiles à d'autres explorant des pistes similaires :

- Le travail en coalition nous a permis d' aborder le problème sous différents angles, en combinant les expertises et en divisant efficacement la charge de travail.

- L’engagement d’une communauté touchée exige du temps, de la transparence et un travail de confiance durable, en particulier lorsque les communautés ont déjà subi des préjudices de la part d’institutions.

- Il est crucial de consulter les communautés concernées à chaque étape du processus.

- Il est important d'être attentif aux préoccupations de la communauté. Les gens craignent généralement d'engager des poursuites judiciaires et de parler aux médias, et beaucoup préfèrent oublier les expériences douloureuses.

En définitive, ces leçons soulignent l’urgence de s’opposer fermement aux pratiques algorithmiques néfastes et de défendre les droits des personnes les plus touchées.

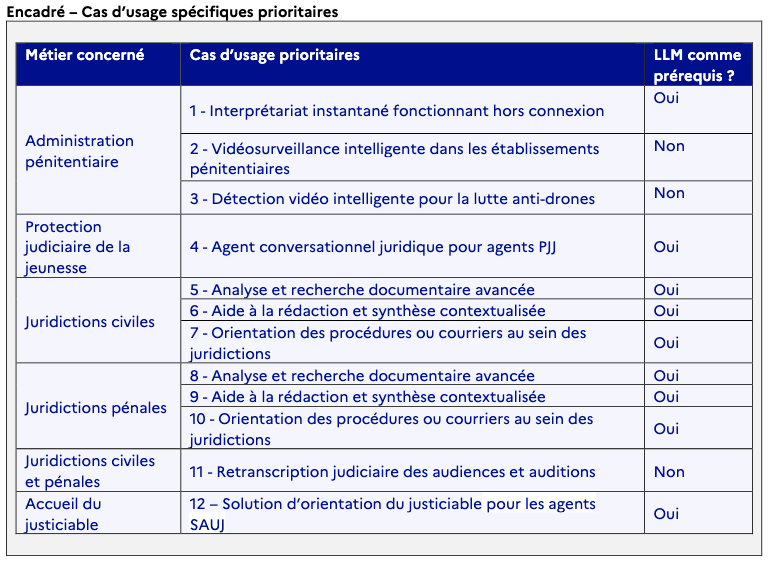

En France, le rapport sur "l’intelligence artificielle au service de la justice", juin 2025

D'après le site Next, il propose de "Créer un assistant IA sécurisé et souverain" à destination des acteurs de la Justice, intégrant, à terme, des fonctions de recherche, synthèse, rédaction et retranscription.

Dès l’introduction, le rapport évacue la question "galvaudée" de la justice prédictive, "sur laquelle il n’apparaît pas pertinent que le ministère s’engage à ce jour si ce n’est pour en démontrer les limites et en combattre les éventuels effets néfastes". Il se concentre plutôt sur des manières d’améliorer "rapidement l’efficacité du travail des agents et la qualité du service rendu aux usagers" en visant à "démocratiser l’usage de l’IA auprès des acteurs de la Justice".

La mise en place serait progressive (acquisition des licences d’outils spécifiques, formation des agents en 2026 et 2027), pour une généralisation en 2027, où l’IA serait "un véritable pilier du service public de la Justice".