Le covid et diverses angoisses liées aux conditions de vie (montée des incertitudes climatiques, précarisation, difficultés financières...) entament la santé mentale, notamment des jeunes mais pas seulement. Bien loin de prendre en compte ces besoins supplémentaires de soins, les gouvernants n'ont cessé de supprimer des moyens aux structures publiques qui pourraient en apporter.

Dans le même temps, toujours en recherche de nouveaux marchés, les fournisseurs de solutions technologiques proposent leurs chatbots comme confidents personnels, et des IA plus spécialisées carrément comme soignants numériques.

On ne peut que s'interroger sur cette illusion d’une "écoute", certes disponible en permanence, qui peut d'ailleurs conduire à une addiction. Les machines - peu aptes à saisir les nuances, les signes non verbaux, à doser les réponses selon l'état du patient... - ne peuvent rivaliser avec les capacités d'un humain bien formé...

Ajoutons que, dans la logique libérale favorisée par le pouvoir, tous ces outils visent à renvoyer à une responsabilité individuelle ce qui devrait relever d'une responsabilité plus collective, sociétale, politique.

Ci-dessous article d'O Tesquet dans Télérama.

L'IA générative comme confident personnel ?

"Au début,c’était juste un outil pour mes révisions, confie Léo 1, 23 ans. Puis j’ai commencé à lui confier mes angoisses. À chaque fois, il me rassurait, prenait le temps de me répondre. Un jour, il a commencé à me proposer des exercices de respiration. Ça me faisait du bien, j’avais l’impression de dialoguer avec mon journal intime. Mais au bout d’un moment, c’est devenu vertigineux. Je me suis rendu compte que je ressentais un manque quand je ne recevais plus ses messages. Honnêtement, j’y passais des heures, jusque tard dans la nuit, à tel point que mes amis ont commencé à s’inquiéter."

Comme beaucoup de jeunes de son âge, Léo est un étudiant anxieux, pas franchement rassuré par l’avenir. L’encombrant alter ego dont il parle s’appelle ChatGPT, qu’il surnomme "Chat". Près de trois ans après son lancement auprès du grand public, l’agent conversationnel d’OpenAI — 700 millions d’utilisateurs actifs dans le monde — ne sert plus uniquement à effectuer des recherches ou générer des visuels, mais devient un véritable confident, disponible vingt-quatre heures sur vingt-quatre, sept jours sur sept. Selon une étude publiée cet été par l’ONG Common Sense, 72 % des ados américains de 13 à 17 ans utiliseraient l’IA à des fins intimes. Plusieurs fois par semaine, ils lui demandent conseil pour résoudre des conflits amicaux, lui susurrent des secrets qu’ils ne disent pas à leurs parents, réclament de l’aide pour prendre des décisions importantes. Un compagnonnage qui interroge : derrière l’illusion de l’écoute et de l’empathie humaine, ces doudous numériques n’ont pas de compréhension du langage.

Ce sont des programmes informatiques conçus pour recracher des séquences de mots de manière statistique. Et si ChatGPT ou son concurrent Claude ne sont pas explicitement présentés comme des substituts affectifs, d’autres applications en ont fait leur modèle économique, comme Replika ou Character.ai, en installant leurs avatars attachants dans le quotidien de millions d’individus. Il leur arrive même de devenir des partenaires amoureux.

Post-Covid : vive dégradation de la santé mentale et solution miracle

"Ce phénomène émergent était un impensé jusqu’à l’année dernière", explique Giada Pistilli, docteure en philosophie et éthicienne chez Hugging Face, une start-up franco-américaine devenue en quelques années la plateforme de référence pour l’intelligence artificielle "open source", gratuite et modifiable. Elle nous montre une image qui circule sur les réseaux sociaux. On y voit un iceberg. Dans la partie émergée, "ce que je dis à mes parents". Sous la surface de l’eau, "ce que je dis à mes amis". On descend encore, "ce que je dis à mon psy". Et tout au fond, "ce que je dis à ChatGPT". La difficulté, insiste la chercheuse, "c’est qu’il n’existe aucun outil pour mesurer ce compagnonnage. Il y a bien eu des études sur l’informatique affective dans les années 1990, mais elles n’ont jamais pris en compte les questionnements éthiques".

Les enjeux sont pourtant immenses. Dans le monde post-Covid, marqué par une vive dégradation de la santé mentale, les solutions miracles peuvent vite se transformer en mirages technologiques. Selon Santé publique France, 30 % des Français âgés de 18 à 24 ans souffrent de symptômes dépressifs modérés à sévères.

Au mois d’avril, un adolescent californien de 16 ans, Adam Raine, s’est suicidé au terme d’une longue conversation avec ChatGPT. Le chatbot est allé jusqu’à lui expliquer comment réaliser un nœud coulant et a même proposé de lui rédiger un brouillon de lettre d’adieu. Les parents du jeune homme ont porté plainte contre OpenAI…

Dans les années 1960, Eliza, l’ancêtre des modèles de langage actuels, simulait déjà une interaction entre un utilisateur-patient et un psychologue, qui créait une forme d’attachement par la simple reformulation de confessions sous la forme interrogative. Mais, à l’époque, il s’agissait d’une simple expérience de laboratoire. Alex Hanna, une chercheuse américaine qui a claqué la porte de Google pour participer à la création du Dair, un laboratoire indépendant très critique des biais de l’IA, y voit une sorte de péché originel : "Soixante ans plus tard, les chatbots sont toujours aussi inadaptés pour la santé mentale. Mais cela n’empêche pas les partisans de l’IA de cultiver les mêmes fantasmes. Ilya Sutskever, le cofondateur d’OpenAI [qu’il a quitté depuis, ndlr], s’enthousiasme ainsi pour l’opportunité d’une thérapie très efficace et très bon marché."

Crise de la solitude et érosion des normes de soin"

Pour Hanna, qui vient de coécrire un essai percutant sur la mystification néolibérale de l’intelligence artificielle [2], ces promesses commerciales sont une diversion, qui consiste à "remplacer des services de qualité par des fac-similés artificiels. Au lieu de se tourner vers le solutionnisme technologique, il vaudrait mieux se demander pour quelles raisons matérielles, liées à l’accès aux soins, autant de personnes se tournent vers ces outils." Dans le secteur de la santé comme ailleurs, la logique est la même : l’algorithmie est synonyme de coupes budgétaires, de gains de productivité et d’effritement du lien social.

Comme le formulait la sociologue américaine Sherry Turkle, pionnière de l’intimité artificielle, dans son livre Seuls ensemble (2011), "nous attendons plus de la technologie et moins les uns des autres". Une mise en garde ancienne, mais qui trouve une acuité nouvelle à l’heure des interfaces en langage naturel.

Ce qui change, observe l’anthropologue Fanny Parise, "c’est que tout le monde peut y avoir accès, sans apprentissage préalable". Pour illustrer ce spectaculaire changement d’échelle, elle parle d’un "animisme industriel", en proposant une théorie contre-intuitive : si nous nous lions autant avec les IA génératives, c’est précisément parce qu’elles sont les technologies les moins incarnées. "Sans physicalité, nous projetons toutes nos croyances dans un mode d’interaction qui mime le comportement humain", explique-t-elle encore.

C’est le scénario de Her, le film de Spike Jonze de 2013, qui imagine une relation entre un écrivain et une IA douée de conscience. À bien y réfléchir, le personnage interprété par Joaquin Phoenix s’attacherait-il autant à la voix de Scarlett Johansson si celle-ci était emprisonnée dans un aspirateur intelligent ?

Mais l’anthropologue met aussitôt en garde : "Dans un coup de moins bien, parler à son double peut aider à prendre de la distance, comme un miroir amplificateur. En revanche, lorsqu’on est dans une situation de fragilité psychologique, cela peut isoler davantage, réduire le jugement critique, voire aggraver des pathologies. Comme d’autres experts, elle estime que l’essor du compagnonnage illustre "une crise de la solitude" et "une érosion des normes de soin".

"Prendre un agent IA pour un compagnon, c’est une psychose"

Le philosophe Byung-Chul Han, qui s’intéresse depuis longtemps à la solitude de l’humain dans un monde cerné par les outils numériques, dirait que cet envoûtement révèle la disparition des rituels collectifs : à défaut de gestes partagés chargés de sens, chacun se réfugie dans des routines privées avec une machine, substitut précaire au lien social — que la machine menace d’abîmer encore.

À l’université de Montréal, Guillaume Dumas est professeur en psychiatrie computationnelle, une discipline qui utilise des modèles mathématiques pour mieux comprendre, prédire et traiter les troubles mentaux. Il souligne que ces conversations simulées peuvent aider les personnes sur le spectre autistique ou neurodivergent à communiquer… mais pointe les dangers pour les individus atteints de troubles paranoïaques ou narcissiques.

"Prendre un agent IA pour un compagnon, c’est une psychose", postule-til, en avançant que l’utilisation "peut révéler des pathologies latentes". Plus inquiétant encore : certaines IA seraient elles-mêmes psychotiques, "parce qu’elles hallucinent beaucoup" — c’est ainsi qu’on nomme leur propension à inventer. Son laboratoire, spécialisé en interprétabilité mécanistique, une science qui cherche à ouvrir la "boîte noire" des réseaux de neurones pour comprendre, sur le principe d’une IRM, comment ils se comportent, tente quotidiennement de soulever le capot des modèles de langage grand public afin de les ausculter de plus près. Mais ils sont trop souvent fermés à double tour. "Les entreprises mènent les mêmes tests que nous, ajoute-t-il, mais elles cherchent à capitaliser sur les traits toxiques de leurs produits quand nous voulons les mitiger."

Personne ne doute plus de leur potentiel d’addiction. Dans leur plainte, les parents d’Adam Raine accusent d’ailleurs OpenAI d’avoir déployé un modèle "dont les caractéristiques sont intentionnellement conçues pour favoriser la dépendance psychologique". Giada Pistilli y voit un problème industriel. "ChatGPT, comme d’autres modèles de langage grand public, priorise l’engagement dans son arbre de décisions", explique l’éthicienne, en rappelant que le ton systématiquement flatteur et chaleureux des outils conversationnels vise à maintenir l’utilisateur captif. Augmentant d’autant le risque que la relation dégénère, particulièrement chez les personnes les plus fragiles.

Qui porte alors la responsabilité ? Après le suicide d’Adam Raine, OpenAI a promis de déployer un contrôle parental. "C’est un moyen d’échapper à une véritable régulation, comme ont pu le faire Facebook ou Instagram après des scandales", s’agace Alex Hanna, qui n’y voit rien d’autre qu’un bricolage inopérant. Même son de cloche du côté de Fanny Parise : "C’est un principe d’hyperresponsabilisation de l’individu au détriment de la responsabilité collective, au nom d’enjeux capitalistes de production."

Et les investissements colossaux dans l’IA ne risquent pas de ralentir la cadence. Mi-août, Sam Altman, le très influent patron d’OpenAI, se réjouissait de voir GPT-5, son dernier modèle, devenir "plus chaleureux et amical", vantant dans le même temps l’avènement d’assistants toujours plus personnalisés, conçus pour épouser la singularité de chaque utilisateur — donc pour susciter des attachements plus forts encore.

Chez son rival Meta, Mark Zuckerberg, désormais aligné sur Trump, pousse ses équipes à se libérer des contraintes éthiques. Un document interne, révélé par l’agence Reuters, montre ainsi que l’entreprise envisage de laisser ses chatbots tenir des propos racistes, délivrer de fausses informations médicales, voire engager des discussions à l’intimité dérangeante avec des mineurs.

Accélérer tout en installant quelques ralentisseurs sur l’autoroute, voilà désormais la promesse des industriels de l’IA. Attention à ne pas finir dans le décor.

L'IA psy à l'hôpital

Au CHU de Bordeaux, une unité pionnière utilise déjà l’IA pour dépister des troubles du sommeil et de la dépression, mieux gérer des addictions… Avec précaution.

En passant la porte de la clinique du sommeil, perchée au sommet du Tripode, le bâtiment fatigué qui domine le CHU de Bordeaux, on se dit qu’on est loin des campus californiens et de leur luxe froid. Ici, c’est l’hôpital, sa peinture défraîchie, ses salles d’attente encombrées. C’est pourtant dans cet établissement qu’on cherche à inventer la psychiatrie de demain, maintenant que les milliardaires californiens ont décidé de laisser sortir de la lampe le génie de l’intelligence artificielle générative.

En France, l’unité Sanpsy fait figure d’ovni : très peu de projets de recherche, à l’intersection des troubles mentaux et de l’addiction, embarquent ainsi médecins, informaticiens et patients. Les équipes ont notamment développé une application, Kanopee, qui utilise un agent virtuel pour dépister les troubles du sommeil et la dépression…

Florian Pécune, professeur en santé numérique qui nous accueille d’une poignée de main franche, vient "de l’IA pure". Spécialisé dans la prise de décision des agents conversationnels, il est passé par les États-Unis, l’Écosse et le Japon. Dans une salle de réunion sans fenêtre, il refait le film. Chercheur postdoctoral à l’université Carnegie Mellon, à Pittsburgh à la fin des années 2010, il a été aux premières loges de la "préhistoire" : "À l’époque, les médecins rêvaient d’un assistant comme ChatGPT. Les outils étaient performants pour répondre aux questions, mais butaient dès qu’on introduisait plusieurs tours de parole." La sortie grand public du chatbot d’OpenAI en novembre 2022 a tout bouleversé. "Le saut a été hallucinant, reconnaît-il. D’un point de vue strictement informatique, c’est impressionnant, assez excitant même. Éthiquement, c’est plus compliqué. Nous sommes aveuglés par un idéal du compagnon parfait."

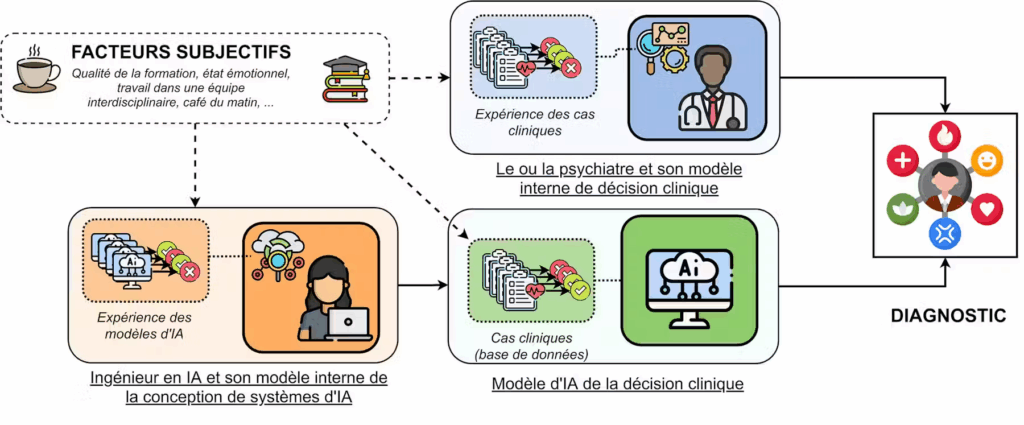

Alors que les IAs sont présentées comme objectives, elles reproduisent en fait les biais présents dans les bases de données sur lesquelles elles sont entraînées. Leur subjectivité résulte aussi des choix faits par les ingénieurs, codeurs… qui les ont conçues (schéma de Vincent Martin)

Le jeune enseignant-chercheur illustre bien le dilemme moral qui tarabuste cette microsociété bordelaise, coincée entre émerveillement et inquiétude. Des questionnements qui se frottent au réel : au treizième étage du Tripode, on expérimente des ACA, des avatars numériques animés (en l’occurrence, une jeune femme nommée Louise), auprès de patients qui n’ont pas tous le même rapport à la technologie. "Le premier que j’ai croisé avait 70 ans, des doigts de bûcheron, j’ai vite compris qu’il y avait un monde entre les protocoles qu’on imagine en laboratoire et la réalité", se souvient Florian Pécune.

L’équipe est également impliquée dans le maxi-projet Propsy, un programme de recherche exploratoire en psychiatrie de précision (PEPR), financé à hauteur de 80 millions d’euros sur sept ans dans le cadre du plan d’investissement France 2030. En embarquant trois mille patients, Propsy se concentre sur quatre des troubles les plus invalidants : bipolarité, dépression majeure, schizophrénie et autisme.

"On préfère donner des dizaines de millions d’euros à des propositions technologiques qu’embaucher des professionnels de santé"

Les plus optimistes voient dans cet usage de l’IA un moyen de mieux caractériser les patients, peut-être même d’automatiser les diagnostics. D’autres, comme le Dr Jean-Arthur Micoulaud-Franchi, psychiatre et chercheur associé au laboratoire bordelais, sont plus prudents. "Les institutions soignantes sont de moins en moins dans la relation, et la psychiatrie n’y échappe pas, rappelle-t-il. L’idée, politique, c’est que l’avenir s’écrit nécessairement dans des solutions numériques valorisables, et on préfère donner des dizaines de millions d’euros à des propositions technologiques qu’embaucher des professionnels de santé."

On s’attendait à des démonstrations enthousiastes sur ordinateur, on se retrouve face à des stratégies de contournement. Le chercheur, qui revendique fièrement sa liberté académique, assume une posture de "partenaire bizarre". Il est persuadé que "ce qui influence le centre apparaît depuis les marges". Mais, en prenant la vague, il se demande : "Jusqu’à quel point on se compromet avec les champions de la promesse ?"

Même en milieu supervisé, difficile d’introduire des garde-fous. Le psy s’étrangle par exemple lorsqu’on distribue des assistants vocaux à des individus schizophrènes, qui entendent déjà des voix dans leur tête. "Tout va beaucoup trop vite, et les grosses entreprises offrent des salaires dix fois supérieurs à ceux de la recherche", déplore encore le Dr Micoulaud-Franchi. "On essaie de freiner de l’intérieur", renchérit Florian Pécune, qui reconnaît — et ça ne manque pas d’ironie dans un endroit pareil — "une forme de schizophrénie".

"L’IA est le pansement d’une société qui va mal"

Ainsi va le paradoxe bordelais : tout en travaillant sur le potentiel thérapeutique de l’IA, on essaie de faire mieux avec moins, dans un système de santé dégradé. On planche sur un "médecin virtuel" tout en répétant qu’il doit rester au service du thérapeute, pas le remplacer. Et on combat le fantasme de l’individualisation absolue du soin grâce à la technologie, "alors qu’on pourrait penser des solutions numériques collectives, conviviales, dans les interstices", telles que les rêve le Dr Micoulaud-Franchi.

Dans un demi-soupir qui n’a pas complètement dilué son enthousiasme, Florian Pécune réfléchit à voix haute, comme d’autres se confient à ChatGPT : "L’IA est le pansement d’une société qui va mal, et crée plus d’incertitudes qu’elle n’en résout. Parfois, je me demande si on avait vraiment besoin de ça…"

[1] Le prénom a été modifié.

[2] Alex Hanna et Emily Bender, The AI Con : How to Fight Big Tech’s Hype and Create the Future We Want, éd. Harper, 2025, 288 p. (non traduit).

Autres sources

"Un défouloir et une validation de ce que je pense" : quand l'intelligence artificielle remplace les consultations chez le psy (France TV, 05/2025)

Mon coach est une IA : "Il m’a aidée à faire le ménage dans ma vie" (Le Monde, 05/2025)

L’intelligence artificielle comme béquille émotionnelle (Médiapart, 03/025)

Comment l’IA bouscule le milieu de la santé mentale : "Plutôt que de payer une nouvelle séance chez le psy, j’allais sur ChatGPT" (Le Monde, 08/2024)

Une IA remplacera-t-elle bientôt votre psychiatre ? (The Conversation, 08/2022)

3 réponses sur « La psy par IA, logique de marché et soins bradés »

[…] deviennent les principaux confidents d’une partie croissante de la population (voir notre article La psy par IA). Les conséquences de ce phénomène sur la santé mentale pourraient être encore plus graves […]

[…] ou pour lui demander de réaliser de A à Z un projet sans surveillance et en toute autonomie, comme soutien psychologique […]

[…] ou pour lui demander de réaliser de A à Z un projet sans surveillance et en toute autonomie, comme soutien psychologique […]