Tous les éditocrates et autres spécialistes autoproclamés s'étalent actuellement avec fascination sur les "performances époustouflantes" et les "dangers" de l'outil ChapGPT et de quelques autres utilisant l'IA. Cela ressemble fort à une promotion de l'IA comme solution miracle à tous les problèmes.

Exemple caricatural : l'émission de 27 sur Arte du 7 mai Intelligence artificielle : révolution ou aliénation ? où étaient invité·es une suédoise promouvant l'IA mais "responsable" (le technowashing habituel), un "conseiller en stratégie" fan de Metaverse et d'IA et, au milieu, Eric Sadin, philosophe apte à dénoncer le "tournant anthropologique" mais pas les conséquences sociales, racistes et de discrimination liées à l'usage de l'IA, pourtant dûment documentées. Et l'animatrice de conclure que, certes l'IA pose des problèmes, mais que c'est incontournable : il suffirait de quelques précautions...

Pourtant, l'IA s'est subrepticement installé dans nos vies depuis le début des années 2000 (par Google, Facebook...) avec la volonté de manipuler nos comportements. Elle est aussi utilisée par les Etats pour traquer les supposés fraudeurs pauvres à la CAF, à Pôle Emploi ou à la Sécu, ou les migrants depuis nos frontières. Bien plus pervers donc qu'une simple falsification lors d'un examen...

A l'occasion du débat sur l'IA act, règlement européen (1) qui visera à cadrer (un peu) l'usage de l'IA, Sarah Chander et Alyna Smith, membres de l'EDRi (European Digital RIghts, ONG qui regroupe nombre d'organisations technocritiques, dont La Quadrature du net), sont les autrices d'une contribution envoyée à la chaine Euronews (quelques extraits ci-dessous, article complet en anglais).

A NOTER : les recherches et législations européennes sur les migrant·es servent de test pour les technologies de pistage qui sont ultérieurement étendues au reste de la population : lors de la répression des manifestants par exemple...

Le réglement de l'UE sur l'intelligence artificielle , communément appelé IA act, est le premier du genre dans le monde, même si d'autres projets de réglementation émergent ailleurs.

Non seulement ce sera un jalon en tant que première législation contraignante sur l'IA dans le monde, mais c'est aussi l'une des premières lois axées sur la technologie à aborder de manière significative la façon dont les technologies perpétuent le racisme structurel.

De l'impact racialement discriminatoire des systèmes de police prédictive à l'utilisation de systèmes d'IA pour étiqueter à tort des personnes (principalement racialisées) comme des fraudeurs lorsqu'elles réclament des prestations, cette législation est profondément éclairée par une prise de conscience croissante de la façon dont la technologie peut perpétuer les dommages.

Les législateurs ont pris des mesures qui interdiraient certaines utilisations de l'IA lorsqu'elles sont "incompatibles avec les droits fondamentaux". C'est le cas de certaines utilisations de la reconnaissance faciale pour identifier les personnes dans les lieux publics et des systèmes d'IA utilisés pour prédire où et par qui des crimes peuvent se produire.

L'IA comme agent de l'immigration

Des détecteurs de mensonges et du "profilage des risques" de l'IA utilisés dans une multitude de procédures d'immigration à la surveillance technologique en pleine expansion aux frontières de l'Europe, les systèmes d'IA sont de plus en plus une caractéristique de l'approche de l'UE en matière de migration.

L'IA est utilisée pour faire des prédictions et des évaluations sur les personnes dans leurs demandes de migration sur la base de critères opaques difficiles à connaître et plus difficiles à contester. Il est prouvé que les décisions de visa reflètent des antécédents de discrimination enracinés dans le colonialisme.

Les systèmes d'IA font également partie d'un appareil de surveillance généralisé en constante expansion. Cela comprend l'IA pour la surveillance à la frontière et les systèmes d'analyse prédictive pour prévoir les tendances migratoires.

Selon le Border Violence Monitoring Network, nous constatons déjà des cas d'utilisation de technologies d'intelligence artificielle dans des refoulements équivalant à des disparitions forcées.

Dans ce contexte, il existe un réel danger que des prévisions apparemment inoffensives sur les schémas migratoires soient utilisées pour faciliter les refoulements, les retraits et d'autres moyens d'empêcher les personnes d'exercer leur droit de demander l'asile.

L'ethnicité et la couleur de la peau deviennent un indicateur du statut d'immigration

Pour les personnes déjà en Europe, la technologie est exploitée par la police locale de manière à augmenter le nombre de personnes identifiées comme sans papiers lors des interpellations policières, perpétuant ainsi le profilage racial.

En France, en Allemagne, aux Pays-Bas et en Suède, la police a reçu le pouvoir de relever les empreintes digitales des personnes qu'elle arrête dans la rue pour vérifier son statut d'immigration.

Des organisations locales de défense des droits de l'homme ont contesté un programme grec équipant la police d'appareils intelligents pour scanner le visage des gens dans le but d'identifier les sans-papiers.

La race, l'ethnicité et la couleur de la peau sont souvent utilisées par les autorités comme indicateur du statut d'immigration.

L'utilisation croissante de l'IA dans le contexte de l'immigration expose les personnes de couleur à plus de surveillance, à une prise de décision plus discriminatoire dans les demandes d'immigration et à un profilage plus préjudiciable (par des logiciels et par des humains), exacerbant les tendances à la criminalisation et à la déshumanisation dans la politique migratoire de l'UE.

Droits numériques pour tous – sauf les migrants

Dans la proposition de réforme Eurodac, l'UE cherche à étendre massivement les bases de données de surveillance avec des données sur les personnes qui demandent l'asile ou qui sont appréhendées à la frontière, pour inclure des images faciales et les données d'enfants dès l'âge de 6 ans.

Ceci est totalement en contradiction avec les normes établies dans le règlement général sur la protection des données de l'UE.

Cet exceptionnalisme coûte des vies et ouvre la voie à l'érosion des propres normes – et valeurs de l'UE. C'est un double standard qu'il faut appeler par son nom : le racisme.

Interdire l'IA nuisible dans la migration

Comme l'ont souligné le professeur E. Tendayi Achiume, ancien rapporteur des Nations Unies sur les formes contemporaines de racisme, et la forte coalition de la société civile #ProtectNotSurveil, nous avons besoin d'un engagement à démanteler les technologies les plus nocives : celles utilisées dans les contextes de migration.

Le réglement sur l'IA doit interdire et empêcher les outils de profilage d'IA discriminatoires en violation du droit international des réfugiés. L'utilisation d'outils d'identification biométrique – comme les appareils portatifs de la police – (sur lesquels la loi est actuellement muette) doivent être classés comme "à haut risque" et donc interdits.

Le réglement sur l'IA ne corrigera pas les politiques migratoires profondément défectueuses de l'Europe. Mais cela peut garantir que les technologies d'IA sont réglementées d'une manière qui empêche d'autres dommages et établisse une protection égale pour tous plutôt que des doubles normes.

(1) Quelques explications sur les enjeux de l'IA Act, actuellement en discussion au Parlement Européen. Ce texte est ambigu :

- d'un côté il va rendre légaux des dispositifs jusque là imposés sans cadre, mais qui pouvaient être contestés en référence aux droits de l'homme ou à des dispositions nationales (cas de 2 grandes actions menées en Pologne et aux Pays-Bas).

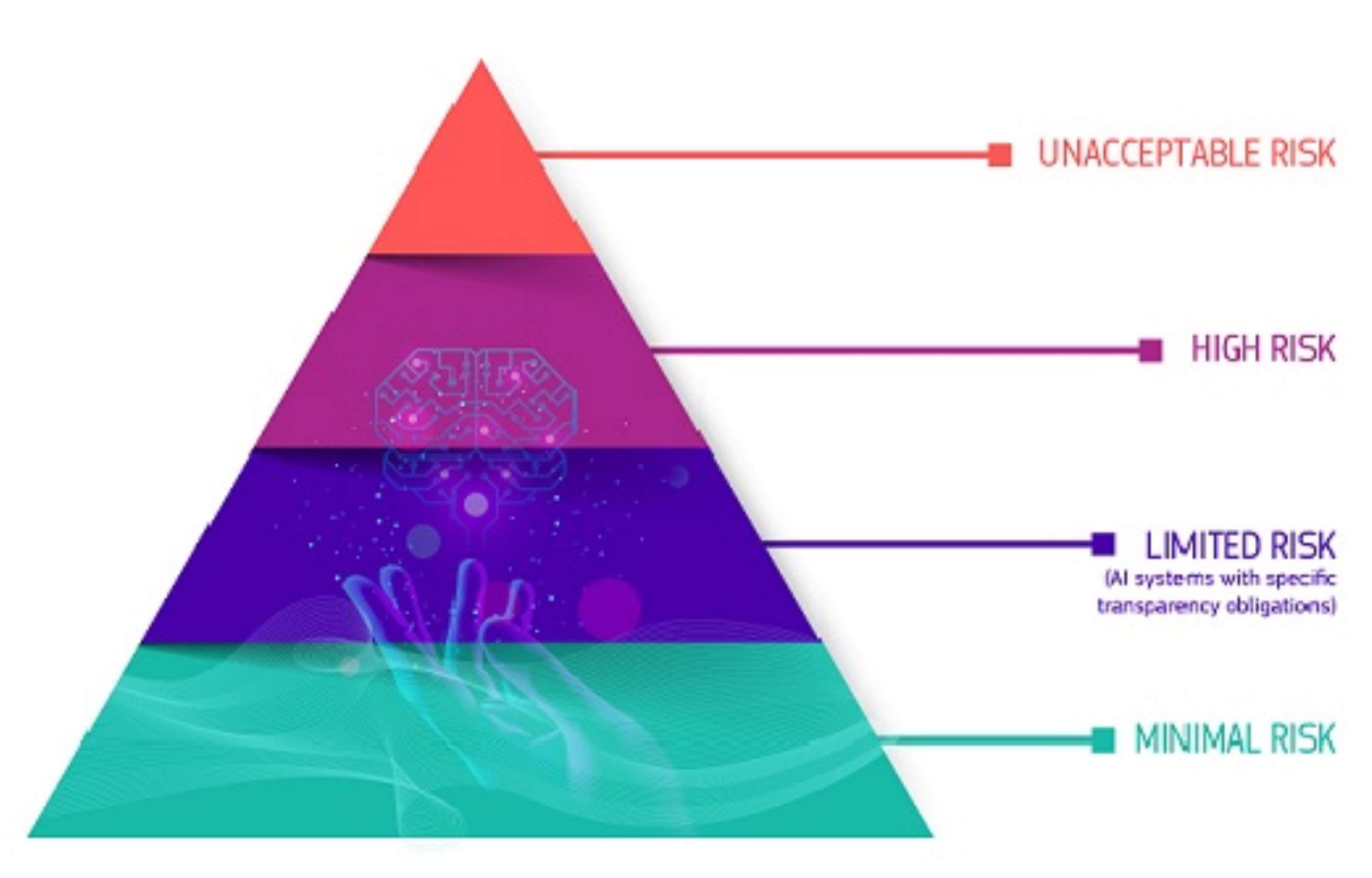

- de l'autre il met en place une classification des systèmes d'IA en 4 niveaux : ceux qui seront interdits (UNACCEPTABLE RISK) / ceux fortement réglementés (HIGH RISK) / ceux pour lesquels on impose des règles de transparence (LIMITED RISK) / ceux sans aucun encadrement (MINIMAL RISK). Les industriels et les gouvernements vont bien sûr essayer de tirer vers le moins réglementé possible (Macron a poussé à ce que certains dispositifs soient carrément considérés comme des exceptions au titre du terrorisme, des menaces sur la santé...). A l'inverse, les assos de défense des droits (et des élus d'opposition) revendiquent le classement en interdit des dispositifs biométriques par exemple. Ainsi, pour ces assos, la récente loi française JO 2024, 1e en Europe à autoriser la visiosurveillance "augmentée", pourrait être déclarée illégale grâce à ce nouveau texte...

Autres sources

Algorithmes, privatisation et contrôle social

Face aux migrant·es, l'UE (et la France) systématisent l'IA

Débat du 8/11/2022 : Intelligence Artificielle et migrants

IA act au parlement UE en avril : recadrage ou promotion de l'IA partout ?

Une réponse sur « Dangers de l'intelligence artificielle : bien plus que par ChatGPT »

[…] Dangers de l'intelligence artificielle : bien plus que par ChatGPT […]