Cela parait très technique, mais beaucoup d'humains sont victimes de ce "scoring", méthode de classement automatisé utilisée par les algorithmes des services publics pour cibler des "suspects de fraude aux allocations".

Ce dispositif, très arbitraire et très difficile à contester, surtout par des personnes marginalisées, faibles face à cet étatisme kafkaïen, conduisent à des détresses sociales immenses, au surendettement sans fin...

Le scoring, machine de guerre des dominants face aux pauvres

Comme mentionné dans notre article "Salauds de pauvres", les gouvernements de droite, en Europe et particulièrement en France (voir rapport du Sénat d'octobre 2019, à la demande d'Edouard Philippe, d'Agnès Buzyn et de Gérald Darmanin, par deux sénatrices LREM et Union centriste) ont lancé depuis, plusieurs années, une offensive, largement idéologique, contre les "fraudeurs aux prestations sociales".

Dès 2021, Vincent Dubois, dans "Contrôler les assistés. Genèses et usages d’un mot d’ordre", montrait que ces dispositifs de scoring aboutissaient au contrôle des plus précaires, des plus pauvres : femmes seules avec enfants, immigré.es récent.es, handicapé.es, habitant.es des quartiers populaires...

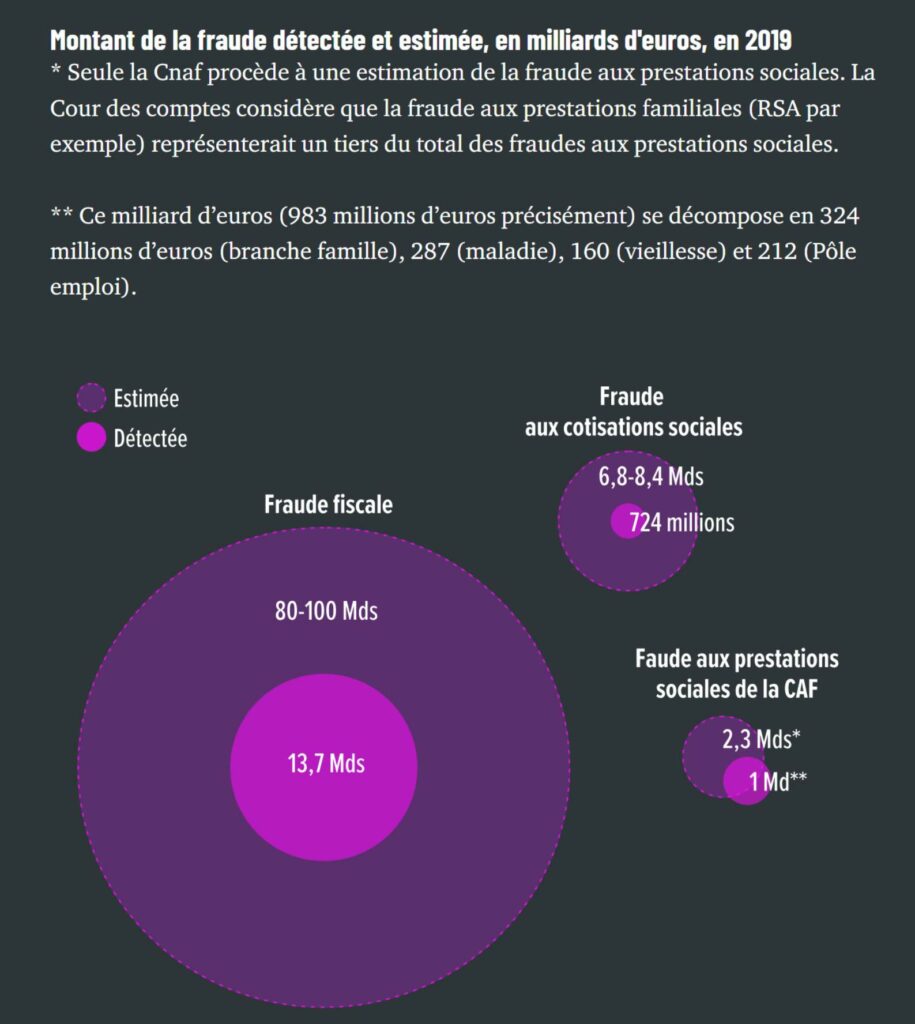

Alors même que cette "fraude aux prestations" (qui recouvre aussi les erreurs attribuables aux Caisses) est bien plus faible que les fraudes fiscales et aux cotisations sociales, beaucoup moins pourchassées... (voir graphique d'Alternatives Economiques ci-dessous). Et qui ignore bien sûr tous ceux et toutes celles qui ne recourent plus à leurs droits (la moitié pour le minimum vieillesse, 34% pour le RSA, 30% pour l'assurance-chômage..., d'après la DREES pour 2022).

Le mécanisme du scoring, production automatisée de la discrimination

D'après Elise Degrave, juriste belge autrice de L'État numérique et les droits humains, "ce type d’algorithme ne cherche pas dans un dossier s’il y a effectivement une fraude puisqu’il n’est pas capable d’identifier « l’intention de commettre une fraude », ce qui est normalement requis par le droit pour sanctionner la fraude. Il ne fait que cibler ce qu’on lui dit de cibler. En l’occurrence, il cherche dans le dossier d’une personne si celle ci a des points communs avec le stéréotype, le « profil », du fraudeur. Si le profil est mal défini (comme « est fraudeur, celui dont le nom est à consonnance étrangère »), des personnes innocentes seront suspectées à tort au regard du droit."

"D’autres, peut-être réellement fraudeuses, échapperont au radar algorithmique. Pour la CAF, la Quadrature du net a souligné que l’algorithme de « lutte contre la fraude » ne cible pas la fraude, mais uniquement les « trop perçus ». Or, ceux-ci ne sont pas nécessairement synonymes de fraude, la plupart étant causés par des erreurs dans les déclarations des ressources des allocataires."

Pour la juriste, "le choix technique fait au moment du paramétrage de l’algorithme est un choix de société, comme le serait la détermination d’une condition fixée dans la loi. Pourtant, la loi des algorithmes n’est pas soumise aux mêmes garanties démocratiques que la loi du parlement."

Or, les conséquences sociales du scoring sont considérables : d’après la Quadrature du Net, "Chaque mois, l’algorithme analyse les données personnelles des plus de 32 millions de personnes vivant dans un foyer recevant une prestation CAF et calcule plus de 13 millions de scores".

L'article 22 du RGPD, arme contre l'usage du scoring ?

L'article 22 du Règlement Général pour la Protection des Données (réglement européen de 2018, applicable à l'identique dans toute l'UE) stipule que "par principe, les individus ont le droit de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé et produisant des effets juridiques la concernant ou l’affectant de manière significative de façon similaire" (d'après la CNIL, qui liste nos droits à l’intervention humaine face à notre profilage ou à une décision automatisée).

Notamment, il imposerait d’"être informé qu’une décision entièrement automatisée a été prise à notre encontre" ainsi que des critères employés, de pouvoir la contester et qu'on puisse demander l’intervention d’un être humain pour son réexamen.

Mais ce texte, prometteur pour nos droits face à l'imposition actuelle de l'IA et des algorithmes dans tous les domaines, n'avait jusqu'à présent été que peu mobilisé pour la défense des habitant.es de l'UE.

L’arrêt SCHUFA du 7 décembre 2023 pris par la Cour de Justice de l'UE (CJUE) amène des perpectives pour d'autres combats juridiques, comme le présente Elise Degrave : "la CJUE a affirmé que l’évaluation de la capacité de remboursement d’une personne par un algorithme est une décision « entièrement automatisée », ce qui [vaut aussi pour] l’évaluation du risque de fraude".

"Un algorithme ne peut pas décider lui-même des personnes à contrôler, à moins que le législateur prévoie des garanties appropriées pour les droits humains et les intérêts légitimes des personnes concernées, comme l’exige le RGPD. Pour ce faire, il pourrait s’inspirer notamment de la directive européenne sur les données des passagers aériens et des décisions de la CJUE (arrêt du 21 juin 2022) et du Conseil constitutionnel français (12 juin 2018) qui interdisent de recourir à des algorithmes traitant certaines données comme l’origine raciale d’une personne, sa religion, son état de santé, son orientation sexuelle, etc. Il devra également tenir compte de l’« AI Act » [ou Règlement IA, applicable depuis août 2024] qui interdit les outils de « notation sociale » classant les individus en fonction de leurs « caractéristiques personnelles réelles, déduites ou prédites » [Article 5.1 c]".

Par ailleurs, l'arrêt SCHUFA permet de dénoncer une collecte massive de données personnelles par une entreprise privée issues de bases de données publiques, qu'elle les conserve bien plus longtemps qu'autorisé, et qui ignore le principe de minimisation des données ("adéquates, pertinentes et limitées...", Article 5 du RGPD)...

Pour Elise Degrave, "doit-on se résigner et admettre que les robots, au sens de « processus automatisés », sont les nouveaux décideurs publics, inspecteurs et assistants sociaux ?". Pour elle, "chacun doit rester libre, par choix ou nécessité, de préférer le contact humain. C’est pourquoi, un nouveau droit fondamental devrait être ancré dans notre Constitution, le droit fondamental de ne pas utiliser internet" et donc d'en subir les conséquences.

POUR EN SAVOIR PLUS : La Quadrature du net, Changer de cap et Halte au contrôle numérique, avec le soutien de la mairie de Villeurbanne* vous invitent, le 18 janvier 2025, à des rencontres à Villeurbanne pour lutter contre la numérisation des services publics

* cette municipalité a voté, en octobre 2023, une délibération "en faveur d'un droit au non-numérique dans l'accès aux services publics municipaux"

6 réponses sur « Face aux discriminations dues au "scoring", l'article 22 du RGPD ? »

[…] - Face aux discriminations dues au "scoring", l'article 22 du RGPD ? […]

[…] Face aux discriminations dues au "scoring", l'article 22 du RGPD ? […]

[…] et leurs conséquences sur nos vies. A noter qu'il existe un droit européen applicable en France (article 22 du RGPD, que nous analysons en nous référant à Elise Degrave, juriste belge), qui prévoit que "les […]

[…] constitutionnelles garantissant l'égalité devant la loi, le dernier utilisant la référence à l'article 22 du RGPD qui stipule que "par principe, les individus ont le droit de ne pas faire l’objet d’une […]

[…] Face aux discriminations dues au "scoring", l'article 22 du RGPD ? (HACN, 11/2024) […]

[…] 7e - celui qui sert pour calculer le score de chaque allocataire des CAF et décide qui doit être contrôlé - suite à l'action devant le Conseil d'Etat de 25 […]