Le Règlement européen sur l'Intelligence Artificielle (RIA pour la CNIL, ou "AI act") est applicable depuis le 1e août 2024 (selon un calendrier progressif, voir plus bas).

Face au 1e projet d'avril 2021, la coalition d'organisations de défense des droits humains #Protect Not Surveil (composée de l'EDRi [dont fait partie La Quadrature du Net], d'Amnesty International, Access Now, Algorithm Watch...) a mené un combat d'ampleur pour obtenir l'interdiction des IA utilisant la reconnaissance faciale en temps réel ou a posteriori, de celles permettant la police et la justice prédictive, l'usage de critères portant sur le genre ou la race, la notation automatisée, l’analyse comportementale (reconnaissance des émotions)...

La bataille menée par cette coalition, passée presque inaperçue en France (essentiellement relayée par Katia Roux, pour Amnesty), avait réussi à obtenir le vote d'un texte au Parlement européen qui reprenait l'essentiel de ses demandes en juin 2023 par 499 voix pour, 28 contre et 93 abstentions, soit à une très large majorité (avec cependant une restriction notable, celle de ne pas protéger les migrants, ce qui avait provoqué un appel en leur faveur de 151 organisations européennes).

Mais les Etats (au premier rang la France macroniste, qui aurait dû renoncer à la VSA...) ont obtenu le déclassement de certains dispositifs "interdits" vers seulement "réglementés", et beaucoup de droits d'exception, ce qui dénature le texte négocié avec le Parlement. La version finale de ce règlement n’interdira pas la surveillance biométrique de masse.

L'EDRi (Europan Digital Rights) garde comme objectif de long terme le texte négocié avec le Parlement. Par ailleurs, elle inventorie ci-dessous quelques axes de contestation qui pourraient y mener.

Sommaire

1. Calendrier d'application du RIA (d'après la CNIL)

2. Quatre niveaux de risque (d'après la CNIL)

3. Extraits de la déclaration de l'EDRi

4. Nos articles sur des thèmes spécifiques d'application nuisible de l'IA (migrant.es, surveillance de masse, guerre pilotée, pauvres, conséquences écologiques...)

5. Nos Articles sur le déroulement de la négociation

1. Calendrier d'application du RIA (d'après la CNIL)

1er août 2024 : entrée en application du règlement

2 février 2025 : Interdictions relatives aux systèmes d’IA présentant des risques inacceptables.

2 août 2025 : application des règles pour les modèles d’IA à usage général, et nomination des autorités compétentes au niveau des États membres.

2 août 2026 : Toutes les dispositions du règlement sur l'IA deviennent applicables, notamment pour les systèmes d'IA à haut risque dans les domaines de la biométrie, des infrastructures critiques, de l'éducation, de l'emploi, de l'accès aux services publics essentiels, de l'application de la loi, de l'immigration et de l'administration de la justice.

2 août 2027 : application pour les jouets, équipements radio, dispositifs médicaux de diagnostic in vitro, sécurité de l'aviation civile, véhicules agricoles, etc.

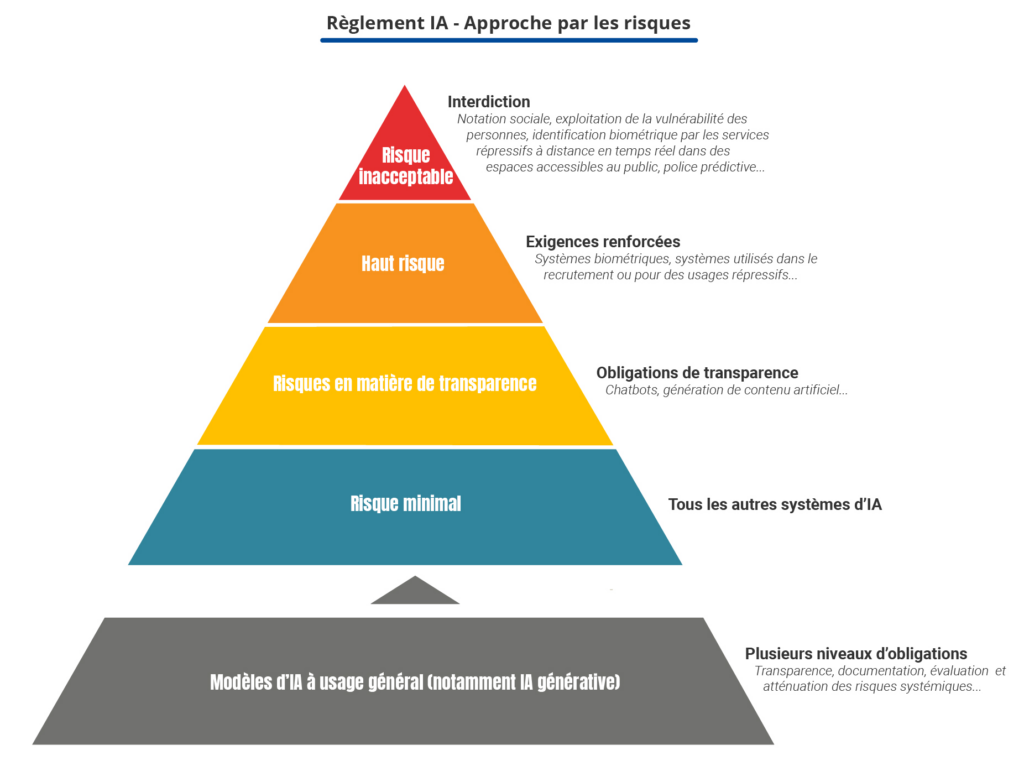

2. Quatre niveaux de risque (d'après la CNIL)

Le RIA propose une approche fondée sur les risques en classant les systèmes d’IA en quatre niveaux :

- Risque inacceptable : le RIA interdit un ensemble limité de pratiques contraires aux valeurs de l'Union européenne et aux droits fondamentaux.

Exemples : la notation sociale, l’exploitation de la vulnérabilité des personnes, le recours à des techniques subliminales, l’utilisation par les services répressifs de l'identification biométrique à distance en temps réel dans des espaces accessibles au public, la police prédictive ciblant les individus, reconnaissance des émotions sur le lieu de travail et dans les établissements d'enseignement. - Haut risque : le RIA définit les systèmes d'IA comme étant à haut risque lorsqu’ils peuvent porter atteinte à la sécurité des personnes ou à leurs droits fondamentaux ce qui justifie que leur développement soit soumis à des exigences renforcées (évaluations de conformité, documentation technique mécanismes de gestion des risques). Ces systèmes sont listés dans l’annexe I pour les systèmes intégrés dans des produits qui font déjà l’objet d’une surveillance de marché (dispositifs médicaux, jouets, véhicules, etc.) et dans l’annexe III pour les systèmes utilisés dans huit domaines spécifiques.

Exemples : systèmes biométriques, des systèmes utilisés dans le recrutement, ou pour des usages répressifs. - Risque spécifique en matière de transparence : le RIA soumet des systèmes d'IA à des obligations de transparence spécifiques, notamment en cas de risque manifeste de manipulation.

Exemples : recours à des chatbots ou à la génération de contenu artificiel. - Risque minimal : pour tous les autres systèmes d'IA, le RIA ne prévoit pas d’obligation spécifique. Il s’agit de la très grande majorité des systèmes d’IA actuellement utilisés dans l'UE ou susceptibles de l'être selon la Commission européenne.

3. Extraits de la déclaration de l'EDRi

L'entrée en vigueur le 1er août 2024 du réglement européen sur l'intelligence artificielle (RIA), est une étape administrative qui signale aux gouvernements et aux entreprises qu'ils doivent se préparer à respecter ces nouvelles règles. A défaut, ils s'exposent à des sanctions lorsqu'ils développent, vendent et utilisent des systèmes d'IA à risque dans l'UE.

L'Acte final (AI act) contient plusieurs pistes de revendication :

- exigences techniques accrues pour les développeurs de systèmes d'IA et règles de transparence pour les entités publiques utilisant ces systèmes, exigences d'accessibilité.

- mesures de réparation pour les personnes affectées, et lignes rouges contre le sous-ensemble d'utilisations les plus nuisibles et violant les droits.

Nous demandons instamment aux décideurs de veiller à :

1. La mise en œuvre respectueuse des droits du règlement sur l'IA au niveau européen et national :

- respecter la Charte des technologies interdites et à risque

- se soumettre aux autorités de contrôle indépendantes

- respecter les lignes directrices et les codes respectueux des droits humains promus par le règlement

- réaliser des évaluations d'impact sur les droits fondamentaux (EIDF).

2. Combler les lacunes laissées par ce règlement :

- mieux protéger les personnes en déplacement

- traiter les impacts environnementaux de l'IA

- supprimer les exemptions à des fins de sécurité nationale

- s'assurer que tous les systèmes (et pas seulement ceux à haut risque) sont accessibles aux personnes handicapées

- mettre fin à l'exportation de technologies d'IA violant les droits à partir de l'UE.

3. Des interdictions ou des limitations nationales supplémentaires concernant l'IA inacceptable et nuisible dans les cas où le règlement sur l'IA le permet, particulièrement nous appelons à l’interdiction de l’utilisation de systèmes d’identification biométrique à distance (RBI) comme la reconnaissance faciale publique.

4. L’arrêt rapide des utilisations non conformes de l’IA.

5. Des processus véritablement transparents et inclusifs. Les normes sont souvent opaques et privilégient les entités privées. Elles doivent être transparentes et inclure dans leur négociation des représentant.es de la société civile.

L'EDRi recommande d'utiliser les ressources suivantes pour placer les droits de l’homme au centre des lois et politiques sur l’intelligence artificielle :

La société civile appelle l’UE à donner la priorité aux droits fondamentaux dans la loi sur l’IA

4. Nos articles sur des thèmes spécifiques d'application nuisible de l'IA

- pour les migrants (Face aux migrant·es, l'UE (et la France) systématisent l'IA, 02/11/2022),

- pour la surveillance de toutes et tous (L’IA act européen validé, un blanc-seing à la surveillance biométrique de masse, 03/04/2024),

- pour la guerre meurtrière (Gaza : tuerie par IA, 07/05/2024),

- contre les pauvres (Des IA pour traquer les pauvres, ces "fraudreurs", 21/08/2023),

- avec des conséquences écologiques majeures (Pollutions, captation d'eau, d'énergie... La faute à l'IA, 23/03/2024)

5. Nos articles sur le déroulement de la négociation

- L’IA act européen validé, un blanc-seing à la surveillance biométrique de masse (03/04/2024)

- Le règlement européen sur l’IA n’interdira pas la surveillance biométrique de masse (25/01/2024)

- IA act : compromis entre les Etats et le parlement de l'UE (10/12/2023)

- IA act : 151 organisations demandent à l'UE de respecter les droits humains, particulièrement ceux des migrant·es (19/08/2023)

- IA act au parlement UE en avril : recadrage ou promotion de l'IA partout ? (14/03/2023)

9 réponses sur « Règlement IA : bataille perdue, mais horizon de conquête »

[…] de santé, son orientation sexuelle, etc. Il devra également tenir compte de l’« AI Act » [ou Règlement IA, applicable depuis août 2024] qui interdit les outils de « notation sociale » classant les […]

[…] artificielle. C'est notamment le cas de l’AI Act adopté par l’Union européenne [appelé Règlement européen sur l'Intelligence Artificielle ou RIA] et présenté comme une réglementation efficace alors qu'elle cherche en réalité à promouvoir […]

[…] des notes et classer les élèves peut être classée comme un usage à haut-risque selon le Règlement européen sur l'Intelligence Artificielle (RIA pour la CNIL, ou "AI act", applicable depuis août 2024). La CNIL met d'ailleurs à […]

[…] reconnaissance faciale est prise en compte dans l'"AI Act" (ou Règlement IA, ou RIA pour la CNIL), applicable par étapes depuis le 1e août 2024 dans toute l'UE. Une bataille […]

[…] criminels, malgré l'interdiction apparente par l'UE des systèmes dits de "police prédictive" du règlement sur l'intelligence artificielle (RIA ou AI […]

[…] été totalement ignorés par l'essai d'affirmation de droits (très modeste) face à l'IA (par l'"AI act" ou règlement IA), ce que 151 organisations de défense des droits humains ont […]

[…] police et justice prédictive... C'est ce qui devait être obtenu par l'AI act européen (ou règlement IA, RIA en France) mais qui a été contourné, notamment par la France macronienne. Ce sont aussi des […]

[…] une solution possible pour la réglementation de l'IA pourrait être d'en limiter certains usages, voire de les interdire totalement (biométrie, IA prédictive...). C'est ce qu'avait élaboré la coalition Protect Not Surveil (dont font partie Amnesty, l'EDRi...) lors de l'élaboration de l'AI act (ils avaient gagné au parlement UE, mais les gouvernements - dont la France - en ont limité les effets par l'adoption massive de droits d'exception (voir bilan de la bataille autour de l'AI act). […]

[…] Comme dans le domaine écologique, la nouvelle commission européenne, entrée en fonction le 1e décembre 2024, a entrepris de détricoter le droit européen de protection des données. Glissement à droite de cet exécutif, pouvoir personnel de la présidente comme moindre résistance aux exigences américaines expliquent ces revirements face à une législation plus protectrice qui se construisait depuis quelques années (autour du RGPD, de la directive ePrivacy, du DSA [Digital Service Act], du règlement IA...). […]