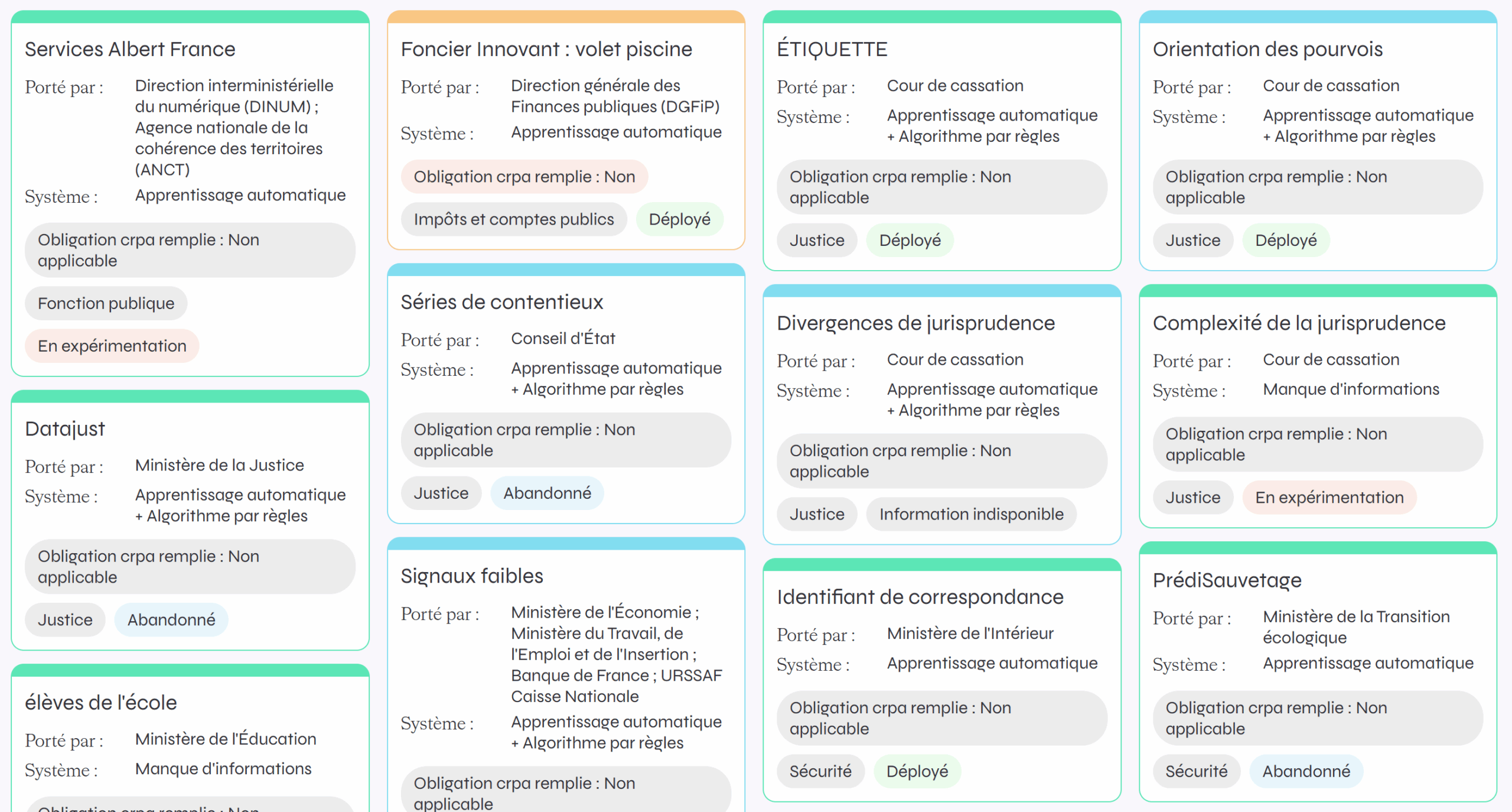

L’Observatoire des algorithmes publics (Odap) cherche à inventorier l'ensemble des algorithmes et systèmes d’intelligence artificielle (IA) utilisés par les administrations françaises (il y en aurait environ 140, 120 sont actuellement analysés par l'ODAP), pour les rendre plus transparents et contribuer à leur évaluation indépendante.

L'idée est de construire une vision critique de ces algorithmes, qui ne sont ni neutres ni autonomes. Ils dépendent en effet de choix politiques dans leur conception mais aussi dans leur usage. Et pour les combattre, il faut les connaître techniquement.

Cet inventaire vient d'être enrichi récemment par un travail militant. Deux membres du collectif ont participé à ces travaux ces derniers mois, avec plus de quarante contributeur·ices universitaires et/ou issu·es de différentes organisations.

Plusieurs de ces algorithmes sont marquants :

- Parole : un logiciel de retranscription des auditions d’enfants victimes auditionnés par la police ou la gendarmerie nationale.

- celui utilisé par la CAF pour "scorer" les allocataires en vue d'un contrôle est actuellement contesté devant le Conseil d'Etat.

- L’algorithme utilisé par la CNAM (caisse nationale d’assurance maladie) pour calculer la probabilité de fraude des bénéficiaires de la complémentaire santé solidaire gratuite.

- Plusieurs systèmes développés par France Travail, notamment le score d’employabilité, ChatFT et MatchFT.

Notre opposition au déploiement de l'IA et des algorithmes

En accord avec la coalition Hiatus (dont nous sommes membres), nous nous opposons globalement au déploiement de l'IA et des algorithmes car, comme souligné dans plusieurs articles

- ils se révèlent un gouffre énergétique, en consommation d'eau et de métaux rares ou moins rares (cuivre par exemple). Pour ces derniers, ils contribuent à une exploitation coloniale des ressources et à des conditions sociales extrèmes (travail des enfants, néo-esclavage...).

- ces algorithmes peuvent se révéler particulièrement discriminatoires, racistes et peuvent promouvoir des idéologies fascistes.

- les Etats - et particulièrement la France - les utilisent pour casser les systèmes sociaux.

Partout nous voulons privilégier la place de l'humain, et dénions donc à ces systèmes automatisés tout droit de décider dès qu'un humain - ou un animal - est concerné.

Plusieurs moyens de lutte doivent être mobilisés

- d'abord obtenir l'absolue transparence de leur usage, notamment par l'obtention systématique de leur code source, comme viennent de le gagner les espagnols de Civio. En France, une loi de 2016 "pour une République numérique" est censée y obliger l'ensemble des administrations. Dans les faits, seuls 6 codes sources sur les 140 possibles sont aujourd'hui accessibles.

- contester juridiquement l'emploi d'algorithmes décisionnaires sur les humains : au niveau européen plusieurs, très dommageables socialement, on été combattus ainsi, victorieusement. En France, 15 associations ont attaqué l'algorithme discriminatoire de la CAF contre les "fraudeur.ses" devant le Conseil d'Etat (affaire encore en cours).

- interdire par la loi le recours à des algorithmes dans toute une série de champs : social, surveillance, police et justice prédictive... C'est ce qui devait être obtenu par l'AI act européen (ou règlement IA, RIA en France) mais qui a été contourné, notamment par la France macronienne. L'EDRi (European Digital Rights) inventorie des pistes juridiques qui permettront, à partir du RIA, d'obtenir ces interdictions. Ce sont aussi des combats portés actuellement aux Etats-Unis (pourtant pays des Trump-Musk & Co !). Par exemple, une loi vient d'être votée en Californie pour interdire la fixation algorithmique des prix (tarification "dynamique"), une élue de Minneapolis veut interdire le recours aux algorithmes pour la fixation des loyers...

Une réponse sur « Un inventaire des algorithmes utilisés dans les services publics »

[…] publiques à communiquer le code source des algorithmes utilisés. Dans les faits, d'après l'ODAP, seuls 6 codes sources sur les 140 possibles sont aujourd'hui […]