Les régimes autoritaires, dictatoriaux, installent la reconnaissance faciale dans les aéroports, les transports collectifs, le contrôle aux frontières et le pistage des migrant.es, les stades... C'est le cas à Singapour, en Chine, en Israël, dans les pays du Golfe, aux Etats-Unis… Son couplage avec l'IA représente un danger majeur pour nos libertés et face aux politiques ségrégatives qui s'installent dans ces pays ... et dans nos contrées supposées libérales.

Comment lutter ? Comment mobiliser face à ces atteintes pour nos droits humains individuels et collectifs ?

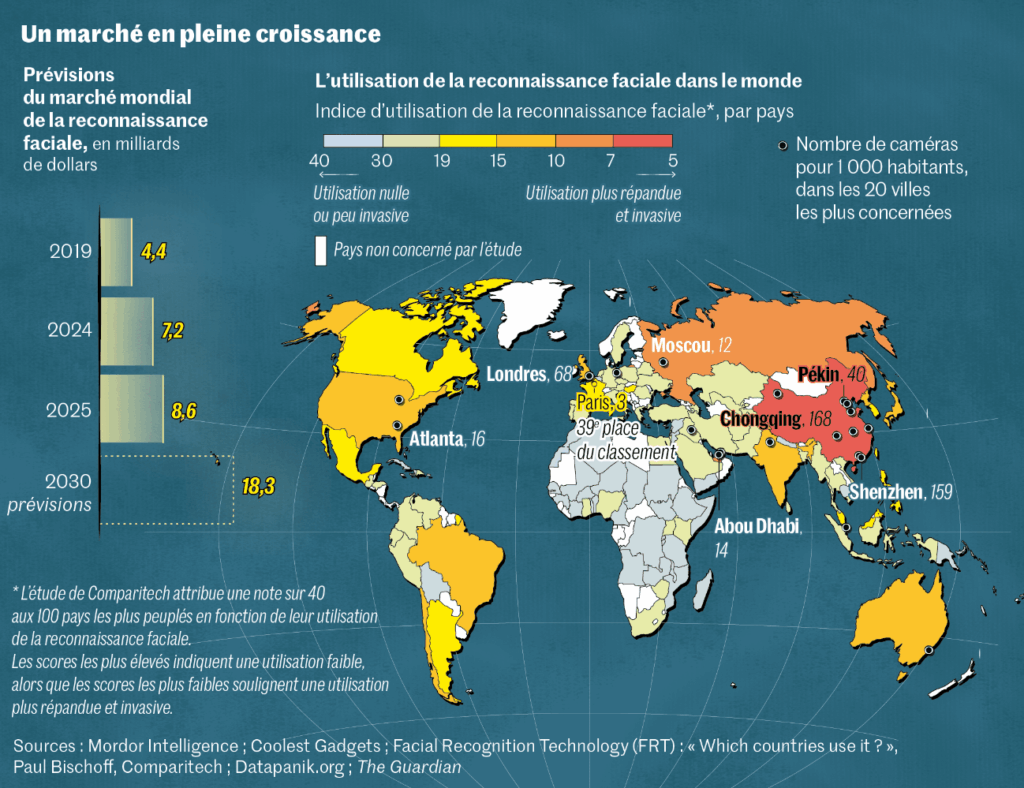

Le journal Le Monde présente la reconnaissance faciale comme un marché juteux qui pourrait peser 18 milliards de dollars (15,4 milliards d’euros) en 2030, contre 8 milliards aujourd’hui. Il nous gratifie d'une de ces infographies censée nous prouver l'inéluctabilité de cette progression.

Dans cette entreprise de banalisation (titre de l'article), ce journal utilise même le témoignage d'une sociologue - Caroline Lequesne, responsable d'un master 2 à l’université de Côte d’Azur - qui nous certifie que "sensibiliser sur le seul terrain des libertés fondamentales ne suffit plus". Les libertés ne sont donc plus fondamentales...

La reconnaissance faciale est interdite, sauf...

En droit, la reconnaissance faciale est interdite en France et dans l'UE, sauf en Hongrie où elle a été autorisé par le Parlement en mars pour identifier les personnes qui organisent ou assistent à la Marche des fiertés, désormais interdite par la loi.

Et la France a initié un dangereux précédent en autorisant, à titre d'expérimentation lors des JO 2024, la VSA (Vidéo-Surveillance Algorithmique, voir notre article). Depuis, les ministres successifs - et les responsables de la région Auvergne-Rhône-Alpes - ne cessent de vouloir réinstaurer l'expérimentation, pour les prochains JO notamment...

Et l'ex-ministre de l'intérieur, aujourd'hui à la justice, Gérald Darmanin, laisse augurer d'une volonté de passage à la "vraie" reconnaissance faciale : le 23 mai il annonçait le lancement d’un "groupe de travail" sur la reconnaissance faciale, qu’il souhaitait mettre en place dans l’espace public et les aéroports.

Laquelle est déjà utilisée de manière illégale : en novembre 2023, Disclose révélait que la police nationale avait recours au logiciel Video Synopsis, de BriefCam (depuis 2015 !). Cette société israélienne continue depuis de "vendre dans les villes leur logiciel de vidéosurveillance algorithmique, et ce qu’il se passait avant les JO se poursuit dans l’impunité la plus totale", pointe Noémie Levain, juriste au sein de La Quadrature du Net. En janvier, le tribunal administratif de Grenoble leur a donné raison dans l’affaire qui les opposait à la ville de Moirans (Isère), en reconnaissant l’illégalité du logiciel de vidéosurveillance de BriefCam utilisé par de nombreuses communes (Roanne...).

Différentes technologies, de plus en plus liberticides

Type de technologie |

Fonctionnement |

Constats |

Authentification, autorisée dans les aéroports |

Comparaison de l’image reconnue avec celle du passeport ou de la carte d’identité |

Dans les aéroports, elle est censée "fluidifier" en gagnant du temps sur la vérification seulement visuelle. Elle n’est pas à l’abri des erreurs, biais... Cet usage très limité peut conduire à glisser vers les autres méthodes |

Catégorisation, |

Analyse, d’après l’image générée, les caractéristiques d’une personne (âge, sexe, couleur de peau…) et ses émotions |

Source de nombreuses erreurs, de biais divers (ces outils distinguent très mal les couleurs de peau sombres, surinterprètent…). |

Vidéo Surveillance Algorithmique (VSA), expérimentée pendant les JO et au-delà (août 2023 à mars 2025) en France |

Se sert de l’IA pour détecter des situations suspectes (mouvement de foule, présence d’armes, émotions…) |

Très intrusive (émotions…) et très normative (courir déclenche une alerte). Lors des JO, taux d’alertes erronées constatées par la SNCF de 62 % ! |

Identification, interdite |

Comparaison de l’image reconnue avec celles stockées dans des bases de données existantes (notamment TAJ : fichier de Traitement des Antécédents Judiciaires, où sont stockées les photos des prévenus, mais aussi des plaignants… ; ou TES : fichier des Titres Electroniques Sésurisés, autrement dit le fichier biométrique qui stocke toutes les données enregistrées lors de la création des cartes d’identité et des passeports) |

Permet d’identifier précisemment une personne dans une foule et d’afficher tous ses attributs stockés dans les fichiers : la surveillance de masse "idéale", à la chinoise, ou la STASI à l'ère numérique |

UE : un cadre réglementaire peu protecteur du fait d'un droit d'exception

La reconnaissance faciale est prise en compte dans l'"AI Act" (ou Règlement IA, ou RIA pour la CNIL), applicable par étapes depuis le 1e août 2024 dans toute l'UE. Une bataille intense a présidé à ce texte, conduite par la coalition d'organisations de défense des droits humains #Protect Not Surveil (composée de l'EDRi [dont fait partie La Quadrature du Net], d'Amnesty International, Access Now, Algorithm Watch...). Elle s'est battue notamment pour obtenir l'interdiction des IA utilisant la reconnaissance faciale en temps réel ou a posteriori, l’analyse comportementale (reconnaissance des émotions)…

Cette coalition avait réussi à obtenir le vote d'un texte au Parlement européen qui reprenait l'essentiel de ses demandes en juin 2023 par 499 voix pour, 28 contre et 93 abstentions, soit à une très large majorité (avec cependant une restriction notable, celle de ne pas protéger les migrants, ce qui avait provoqué un appel en leur faveur de 151 organisations européennes).

Mais, dans un deuxième temps, sont intervenus les Etats (au premier rang la France macroniste, qui aurait dû renoncer à la VSA...) qui ont obtenu le déclassement de certains dispositifs "interdits" vers seulement "réglementés", et beaucoup de droits d'exception, ce qui dénature le texte négocié avec le Parlement. La version finale de ce règlement n’interdit pas la surveillance biométrique de masse.

Katia Roux, qui a participé aux négociations pour Amnesty International, souligne ainsi que des dérives sont possibles suivant l’usage que l’on décide de faire de ces technologies. "L’AI Act encadre partiellement la reconnaissance faciale en temps réel, mais on voit bien que son usage peut être aussi problématique a posteriori, quand des manifestants sont arrêtés plusieurs jours après."

En octobre 2024, la commission européenne a proposé la création d’une "application de voyage numérique" au sein de l’UE afin que les passagers puissent stocker sur leur mobile les informations de leur passeport ou de leur carte d’identité et une image faciale. Ella Jakubowska, de European Digital Rights (EDRi), précise : "Cette proposition implique la création de 27 nouvelles bases de données biométriques contenant les données faciales de potentiellement tous les voyageurs, ainsi qu’une forme totalement inédite de traitement de données sensibles aux frontières européennes", phénomène qui pourrait s'amplifier en cas de piratage de ces données.

Il est donc avéré que le règlement IA ne protège pas. Pour autant, le travail mené dans le cadre de la coalition #Protect not surveil peut à l'avenir amener des combats juridiques et militants pour obtenir progressivement ce qui avait été négocié, à savoir l'interdiction de la reconnaissance faciale en temps réel ou a posteriori, et celle de l’analyse comportementale...

Comment mobiliser sur ces questions de liberté qui nous concernent toutes et tous ?

La Quadrature du net a lancé une action nationale pour s'opposer à la VSA qui propose des explications sur les enjeux, un kit d'actions à mener dans sa ville. Et, par ricochet, à la reconnaissance faciale.

Notre collectif Halte au contrôle numérique a relayé cette action à Saint Etienne (et dans des villes environnantes), avec notamment une pétition à signer.

D'autres modes d'action, plus offensifs, doivent nous inspirer : notamment cette action de Big Brother Watch, un groupe britannique de défense des libertés publiques.

Dans un rapport de 2023, il analyse que, sur un total de 3 315 identifications réalisées par la police, seules 340 étaient vraies.

Il initie une action très offensive : Campagne Big Brother Watch en Grande Bretagne. Présentation par eux :

Au Royaume-Uni, la police et les entreprises privées utilisent de plus en plus la reconnaissance faciale pour nous surveiller, nous catégoriser et nous suivre.

Cette technologie crée une "empreinte faciale" de chaque personne passant devant une caméra, traitant des données biométriques aussi sensibles qu'une empreinte digitale, souvent à notre insu et sans notre consentement.

Cette surveillance dangereusement autoritaire constitue une menace pour notre vie privée et nos libertés. Elle n'a pas sa place dans les rues britanniques.

Nous soutenons une action en justice révolutionnaire visant à faire reculer la reconnaissance faciale orwellienne.

Autres sources

L’entreprise américaine Palantir suspectée de créer une base de données géante sur les citoyens (Le Monde, 08/2025)

JOP2030, retour de la VSA et de la reconnaissance faciale (HACN, 06/2025)

Le Conseil Constitutionnel censure la prolongation de la VSA (HACN, 05/2025)

Les données personnelles des Français de plus en plus piratées en ligne (Le Monde, 04/2025)

Un logiciel de reconnaissance faciale utilisé illégalement dans des dizaines de courses organisées en France (Le Monde, 03/2025)

Non à la reconnaissance faciale, non à la VSA ! Victoire à Moirans... (HACN, 02/2025)

Atelier Police / surveillance numérique (HACN, 10/2024)

JO 2024 : l'extension du domaine de la surveillance, en France (HACN, 04/2024)

La police nationale utilise la reconnaissance faciale de façon illégale depuis 2015 ! (HACN, 04/2024)

Par ces fichiers, l'Etat organise son contrôle et sa domination sur la population (HACN, 10/2022)